作为一名合格的seo工程师,分析网站日志数据是必备技能,如果面试SEO岗位,只懂文章编辑、关键词布局、内链、外链这些技术,只能说明刚入门,还没有成为一位真正的seo工程师,看一个人的seo水平,就问他怎么分析服务器上日志文件,日志文件中有哪些数据,就基本判断八九不离十。

我们购买了阿里云服务器之后,分析网站的seo数据,其中分析云服务器上的日志文件是日常工作。

1、分析爬虫数据

2、分析爬虫请求页面的返回码

3、分析云服务器日志中的404返回码、503返回码等异常数据

4、分析伪装爬虫的ip数据

5、分析网站攻击数据

可见,网站日志是多么重要,讲解一下利用vbscript脚本语言怎样读取和拆分阿里云服务器上的日志文件。

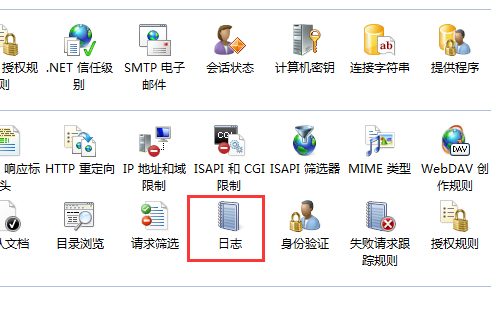

站点的日志文件路径可以在iis信息服务管理器,点击站点,在右侧的视图中,有个日志图标。

点击日志文件,就会出现当前站点下的日志文件路径,当然路径可以自定义设置,日志文件生成时间可以按照小时、天、周、月来设定。这样我们就可以对云服务器上网站日志进行分析,如果懂excel并熟练应用,可以将日志文件直接导入excel中进行分析,excel中有一个导入外部文件功能,支持文本格式。

如果对excel中宏编程不太熟悉,那么可以使用vbscript脚本编写程序对日志文件进行分析。

比如分析百度蜘蛛访问数据,首选通过脚本编写读取日志文件,一行一行循环读取,当一行中含有baiduspider特征字符时,直接付给一个变量,这种不断拼接成新的字符串,重新生成新的文本文件,就完成了含有百度蜘蛛访问的文件,单独出来进行分析。

如果再想分析百度爬虫中含有404的网址数据,我们可以再对已经拆分出来的爬虫数据文件,再一次重复循环含有404特征的字符串进行拼接,重新生成新的文本文件,就得到我们想要的数据。